現在AI(人工知能)の研究が益々盛んになっていますよね。その中で研究が最も盛んな分野のひとつにコンピュータビジョン(Computer Vision)という領域がありますが、この領域で最も大きな成功を成し遂げたモデルのひとつであるResNet(レズネット)に関してご紹介しましょう。

ちなみにコンピュータビジョンというのは、コンピュータに対して画像や動画をいかに認識させることができるかを研究する分野で、深層学習の登場以降AI関連で非常に盛り上がりを見せています。

ResNet(レズネット)とは

コンピュータビジョンでは2012年のAlexNetを皮切りに様々な畳み込みニューラルネットワーク(Convolutional Neural Network; CNNとも呼ばれます)のモデルが提案されてきました。なかでもResNetは2015年にMicrosoft Researchによって提案されて以降、画像認識分野で最も成功を収めたモデルのひとつと言えます。

ResNetのすごさ

2015年当時、画像認識において一般的にCNNの層の数を増やせば増やすほど、モデルが高次元の特徴を獲得していくということは知られていました。しかし単純に層を重ねていくだけでは勾配消失問題によって学習がうまく進まなくなる問題がありました。

勾配消失問題 (gradient vanishing problem)

勾配消失問題(こうばいしょうしつもんだい)とは、ニューラルネットワークを学習させる際の逆伝播時にネットワークの最初の方の層まで勾配が十分に伝わらず、学習が上手くいかないという問題です。

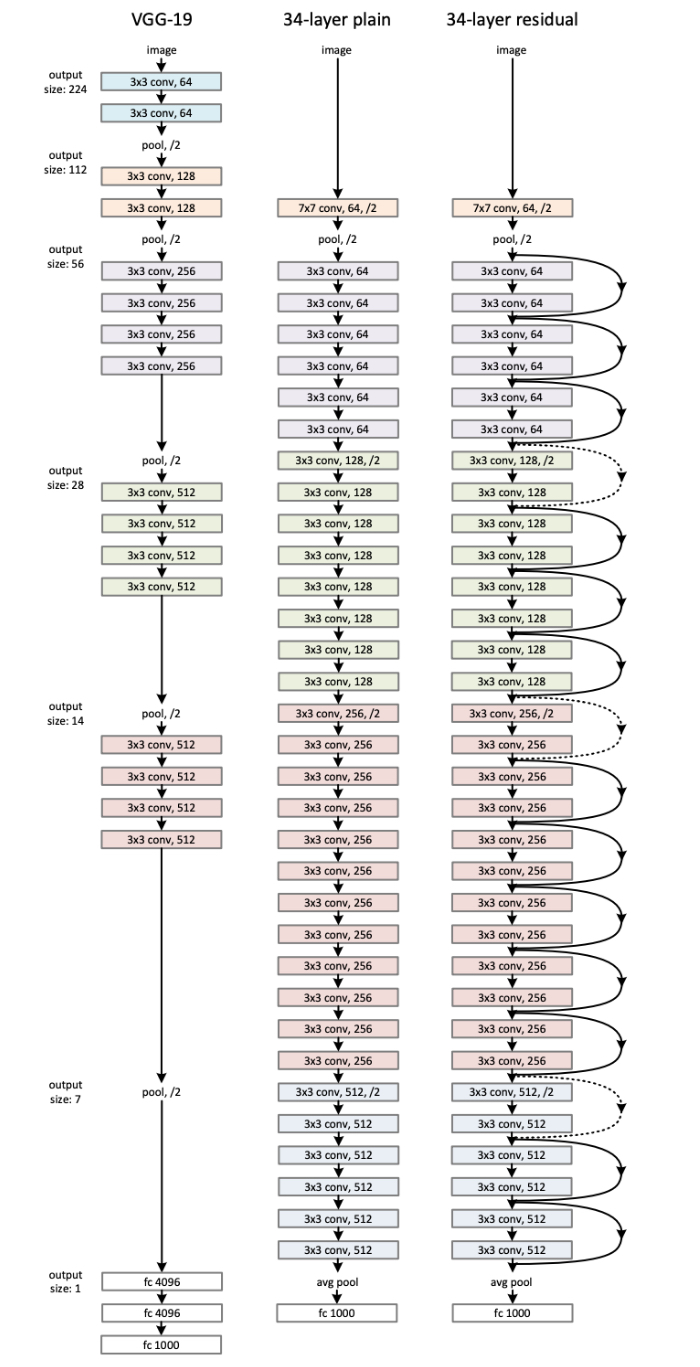

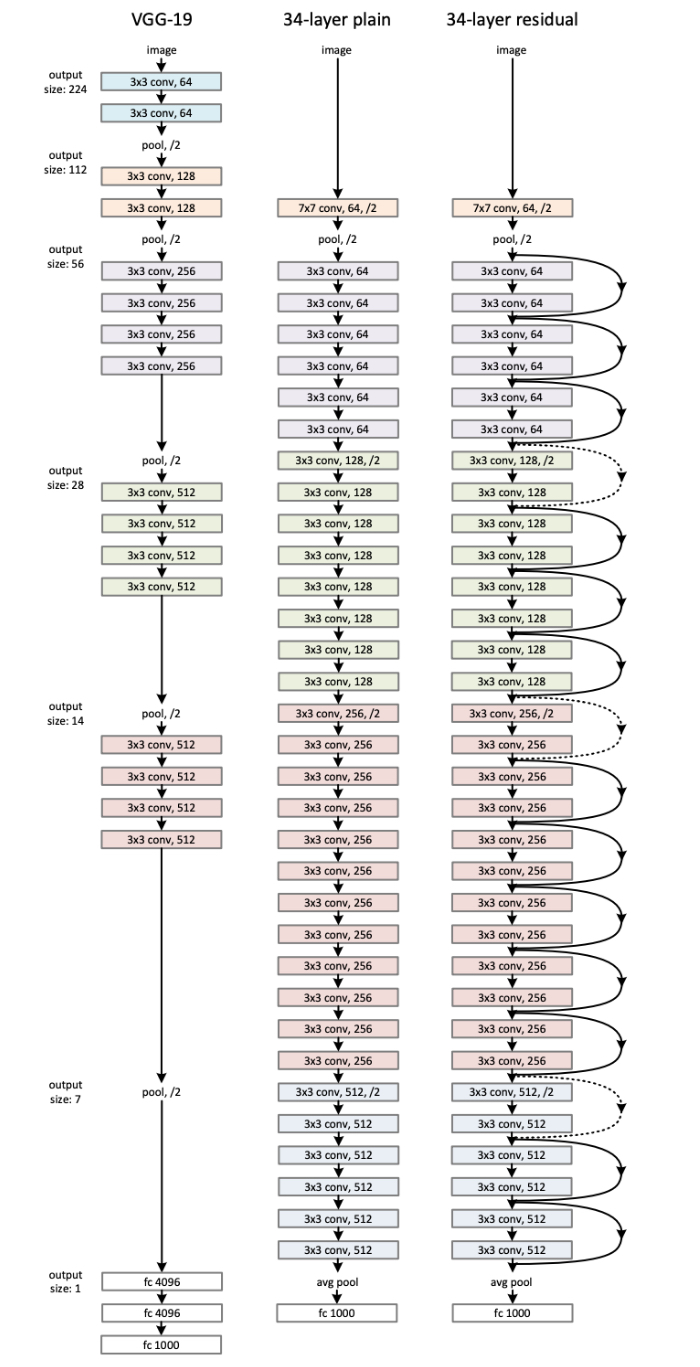

ResNetではこの勾配消失問題を解決するshortcut connectionという仕組みを提案しました。これにより2014年以前はせいぜい20層程度(VGGの16または19層、GoogleNetの22層など)しか層を重ねられなかったCNNですが、ResNetでは152層もの層を重ねることに成功しました。

shortcut connection

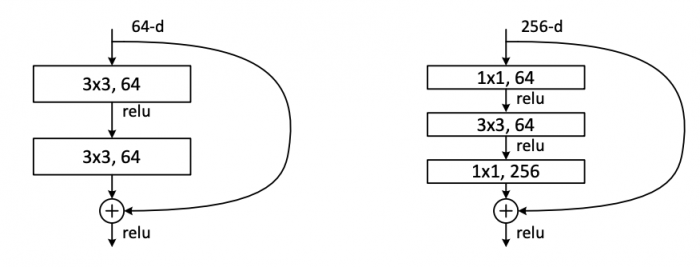

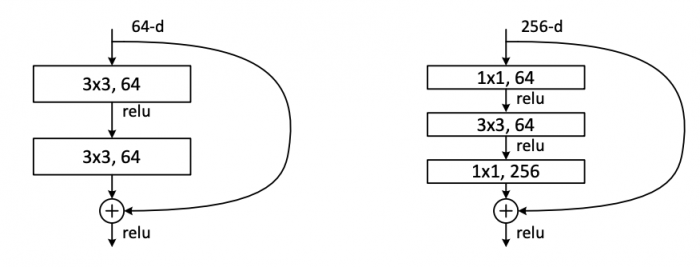

ここではResNetにおける大きな貢献であるshortcut connectionという仕組みに関して説明しましょう。

以下の図のように手前の層から来た入力をいくつかの層を飛ばして、その後に普通に計算された値と足し合わせるという仕組みを持っています。これによって飛ばされたいくつかの層は手前の層からの入力との誤差(residual)のみを予測すれば良いということから、Residual Networks (ResNet)という命名がなされています。

https://arxiv.org/pdf/1512.03385.pdf より引用

まとめ

ResNetについて重要な点をまとめます。

- 2015年にMicrosoft Researchから発表された、現在のコンピュータビジョンにも大きな影響を与えているモデル

- 2015年のILSVRC優勝モデル

- shortcut connectionの導入により勾配消失問題を解決し、その結果152もの層を重ねて学習ができた